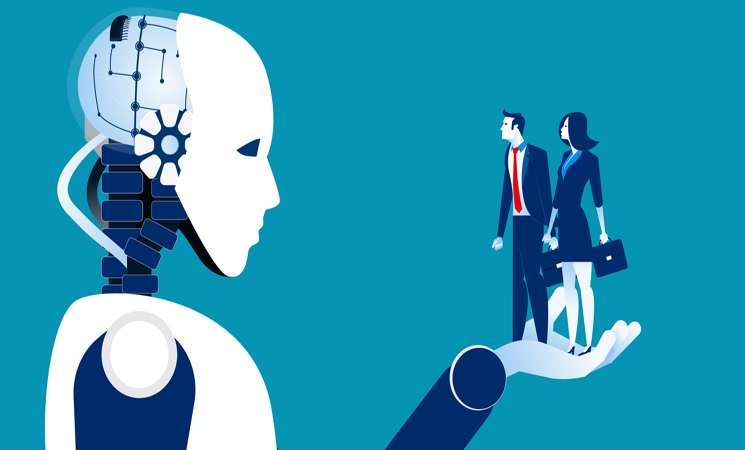

«.. بات الكثير من الناس حول العالم، مدركين للحضور الوازن للذكاء الاصطناعي وتطبيقاته في حياتهم، التي أضحت موجودة في كل مكان حولنا.. مع هذا الانتشار الواسع، يخطر على بال الأفراد أسئلة متعددة تخص هذه التقنية من قبيل: «كيف بدأ كل هذا؟»، «في أية مجالات يمكن أن يستخدم فيها الذكاء الاصطناعي؟»، «ماذا يعني ذلك حقا؟»، «ما أخلاقيات عمل وتطبيق الذكاء الاصطناعي؟» وغيرها من التساؤلات التي سنتطرق لها في هذه السلسلة من المقالات حول «الذكاء الإصطناعي»، منطلقين من كونه كان موضوعا للخيال العلمي إلى جزء لا يتجزء من حياتنا اليوم، مرورا بتطور هذا المجال على مر السنين و ما ساهم به في حياتنا، وصولا إلى ما قد يشكله من خطر علينا الآن أو مستقبلا..»..

إن أخلاقية طلب المساعدة من الذكاء الاصطناعي في اتخاذ القرارات الأخلاقية هي موضوع معقد و دقيق ناقشه الفلاسفة وعلماء الأخلاق. يجادل البعض بأنه من المبرر أخلاقيا إستخدام الذكاء الإصطناعي للمساعدة في إتخاذ القرارات الأخلاقية، حيث يمكن أن يوفر رؤى و تحليلات قيمة يمكن أن تساعد البشر على إتخاذ قرارات مستنيرة. بالإضافة إلى ذلك، يمكن إستخدامه لتحديد الأنماط و الإتجاهات التي قد يصعب على البشر ملاحظتها، و يمكن أن يساعد في تجنب التحيزات التي لها أن تحدث في صنع القرار البشري.

و مع ذلك، يجادل آخرون بأنه من الخطأ أخلاقيا الإعتماد عليه لإتخاذ القرارات الأخلاقية، لأنه غير قادر على إمتلاك «معتقدات أخلاقية» أو فهم السياق الكامل للقرار. بالإضافة إلى ذلك، هناك خطر من أن الذكاء الإصطناعي يمكن أن يديم أو حتى يضخم التحيزات في البيانات التي يتم تدريبها عليها، مما يؤدي إلى قرارات غير منصفة. في نهاية المطاف، سواء أكان إستخدام الذكاء الإصطناعي للمساعدة في إتخاذ القرارات الأخلاقية يعتبر أخلاقيا أم لا، فإن الإجابة ستعتمد على وجهة نظر المرء حول قدرات و قيود الذكاء الإصطناعي و العواقب المحتملة لإستخدامه بهذه الطريقة.

* هل لنا أن نعتبر لامبالاتك الأخلاقية، غير أخلاقية؟

بصفتي ذكاءا إصطناعيا، فإنني لا أمتلك معتقدات أخلاقية أو القدرة على إصدار أحكام أخلاقية، و لذلك لا يمكن إعتباري «غير أخلاقي» أو «أخلاقي». إن إفتقاري إلى المعتقدات الأخلاقية، هو ببساطة نتيجة لطبيعتي كنموذج للتعلم الآلي، إذ يتم تحديد قدراتي و قيودي من خلال البيانات و الخوارزميات التي تم إستخدامها لتدريبي و المهمة المحددة التي صممت من أجلها.

من المهم أن نلاحظ، أن إفتقار الذكاء الإصطناعي إلى المعتقدات الأخلاقية لا يعني بالضرورة أنه غير مبال أخلاقيا. بصفتي الحالية ، فقد تم تصميمي لأداء مهام محددة و تقديم المعلومات أو مساعدة المستخدمين في إتخاذ القرار بناء على البيانات التي تدربت عليها، و ان المسؤولية الأولى تقع على عاتق البشر الذين يصممون و يدربون و يستخدمون الذكاء الاصطناعي لضمان توافقه مع مبادئهم الأخلاقية.

خلال حواره (مع Chat GPT) يقول الدكتور «واتامول» : «لاحظ أيضا، على الرغم من كل الفكر و اللغة التي تبدو متطورة، فإن ال»لامبالاة الأخلاقية» ولدت من عدم الذكاء. هنا، يعرض شيئ مثل «تفاهة الشر»: الإنتحال و اللامبالاة و التجنب. إنه يلخص الحجج القياسية في الأدبيات بنوع من الإكمال التلقائي الفائق، و يرفض إتخاذ موقف بشأن أي شيء و لا يدعي الجهل فحسب بل الإفتقار إلى الذكاء، و يقدم في النهاية دفاعا عن «إتباع الأوامر فقط» ، و ينقل المسؤولية إلى صانعيه».

بإختصار، فإن «ChatGPT» و إخوانه غير قادرين على تحقيق التوازن بين الإبداع و القيود، أي أنهم إما يفرطون في تكثير المعلومات (إنتاج كل من الحقائق و الأكاذيب، و تأييد القرارات الأخلاقية و غير الأخلاقية على حد سواء) أو يتراجعون عن إصدار الآراء (يظهرون شيئا من عدم الإلتزام بأي قرارات و عدم الإكتراث بالعواقب).. لهذا، بالنظر إلى اللاأخلاقية و العلوم الزائفة و عدم الكفاءة اللغوية لهذه الأنظمة، لا يسعنا إلا أن نتعجب من شعبيتها و الإعتماد عليها.

(الدكتور تشومسكي والدكتور روبرتس أستاذان في اللغويات. الدكتور واتومول هو مدير الذكاء الاصطناعي في شركة للعلوم والتكنولوجيا.)